[ad_1]

هل تدعم استقالة جيفري هينتون مطالب «ضبط جماح» الذكاء الصناعي؟

خبراء تحدثوا لـ«الشرق الأوسط» عن 6 مخاطر يجب تجنبها

الأربعاء – 13 شوال 1444 هـ – 03 مايو 2023 مـ

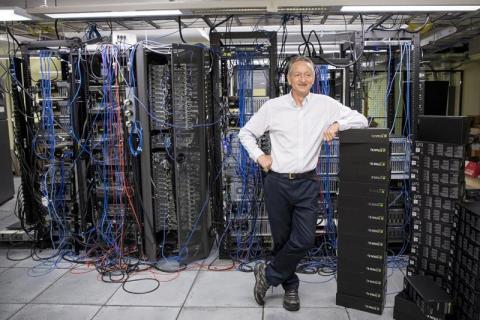

هينتون الأستاذ بجامعة تورونتو والخبير السابق لدى «غوغل» (جامعة تورونتو)

القاهرة: حازم بدر

كما ندم ألفريد نوبل على اختراع الديناميت، وكفّر عن ذنبه بتخصيص جائزة نوبل للأبحاث التي تفيد البشرية، فإن «عرّاب الذكاء الصناعي» جيفري هينتون، الذي قادت أبحاثه في خوارزميات التعلم الآلي إلى كثير من تطبيقات الذكاء الصناعي؛ منها «تشات جي بي تي»، يبدو أنه يشعر بنفس المشاعر، لكنه اختار طريقاً آخر يكفر به عن ذنبه، وهو الحديث عن أخطار السلاح الذي أسهم في إنتاجه.

وفي مفاجأة صادمة، استقال هينتون من منصبه في «غوغل»، قائلاً في تغريدة نشرها على حسابه بموقع «تويتر»، إن «ذلك سيساعده على الحديث بأريحية بشأن مخاطر الذكاء الصناعي».

وعمل هينتون على خوارزميات التعلم الآلي في «غوغل» لأكثر من عقد قبل مغادرته الشركة، وبحسب ما ورد في تقارير صحافية، فإن عمله المستمر على الشبكات العصبية أكسبه لقب «الأب الروحي للذكاء الصناعي».

وتأتي هذه الاستقالة وسط مخاوف متزايدة بشأن استخدام الذكاء الصناعي في مختلف الصناعات، بما في ذلك الرعاية الصحية والتمويل والنقل، ويجادل منتقدوه بأن الذكاء الصناعي يمكن أن يؤدي إلى الاستغناء عن الوظائف وانتهاك الخصوصية وحتى تطوير أسلحة مستقلة.

في مقابلة مع صحيفة «نيويورك تايمز» نُشرت أول مايو (أيار) الحالي، صرح هينتون بأنه كان أكثر قلقاً بشأن استخدام الذكاء الصناعي لإغراق الإنترنت بالصور ومقاطع الفيديو والنصوص المزيفة، لدرجة أن الناس «لن يكونوا قادرين على معرفة ما هو حقيقي».

كما أبدى تخوفاً من أن تحل تكنولوجيا الذكاء الصناعي محل العمالة البشرية؛ حيث يعتقد أن الذكاء الصناعي يمكن أن يشكل تهديداً للبشرية في المستقبل، بسبب قدرته على اكتساب سلوكيات غير متوقعة من الكميات الهائلة من البيانات التي يحللها، وأعرب عن بعض الأسف على مساهماته طوال حياته، قائلاً: «أعزّي نفسي بالعذر العادي: لو لم أفعل ذلك، لكان شخص آخر يفعل ذلك».

وتسببت مبررات استقالة هينتون في حدوث صدمة بجميع أنحاء صناعة التكنولوجيا؛ حيث يراها العديد من الخبراء الذين استطلعت «الشرق الأوسط» آراءهم، داعمة لمزيد من الرقابة والتنظيم لضبط جماح الذكاء الصناعي.

وفي الأشهر الأخيرة، أعرب كل من المنظمين والمشرعين وقادة صناعة التكنولوجيا عن قلقهم بشأن تطوير الذكاء الصناعي. ووقّع أكثر من 2600 من المديرين التنفيذيين والباحثين في مجال التكنولوجيا على خطاب مفتوح في مارس (آذار) أعدّه معهد «فيوتشر أوف لايف» بأميركا، وطالبوا فيه بتعليق مؤقت لتطوير الذكاء الصناعي لحين وضع قوانين تضبط جماحه، مشيرين إلى «المخاطر الجسيمة على المجتمع والإنسانية».

وفي أبريل (نيسان)، وقع 12 مشرعاً من الاتحاد الأوروبي على رسالة مماثلة، ويصنف مشروع قانون حديث للاتحاد الأوروبي أدوات الذكاء الصناعي وفقاً لمستويات المخاطر الخاصة بها، بالإضافة إلى ذلك، ستقدم المملكة المتحدة 125 مليون دولار لفريق العمل لتطوير «الذكاء الصناعي الآمن».

يقول لويس مونيز بيريرا، أستاذ علوم الكومبيوتر ومدير مركز الذكاء الصناعي في الجامعة الجديدة في لشبونة بالبرتغال، وهو أحد الموقعين على خطاب مارس، لـ«الشرق الأوسط»: «بالإضافة لخطري الصور والفيديوهات والنصوص المزيفة، وإحلال التكنولوجيا محل البشر في الوظائف، فإننا مقبلون على خطر ثالث، وهو (حياة القص واللصق)».

ويوضح أنه «قريباً سنتحدث إلى بعضنا في الشبكات الاجتماعية بطريقة (القص واللصق)، لأنها الطريقة التي يتيحها تطبيق الذكاء الصناعي (تشات جي بي تي)، وهي ستكون أقل مجهوداً، ولن يتطلب الأمر تفكيراً نقدياً».

ويضيف: «تشات جي بي تي يعتمد على نموذج اللغة الكبير (LLMs)، الذي يتيح إجابات نموذجية صماء بلا إبداع، لأنه لا يمتلك تفكيراً نقدياً».

ويشير بيريرا إلى أن هذا المعنى عبّر عنه الفيلسوف المشهور ديفيد بابينو من كلية كينجز لندن، عندما قال في مؤتمر عبر الإنترنت: «أتصور الآن في الغالب الأشخاص الذين يتحدثون إليّ على أنهم (تشات جي بي تي)، فهذا التطبيق سيغير من الكيفية التي يتصور بها بعضنا بعضاً».

ويأمل مدير مركز الذكاء الصناعي بالجامعة الجديدة في لشبونة أن تعطي استقالة هينتون مزيداً من الاهتمام بهذا الأمر، الذي يراه الأكثر خطراً من بين الأخطار التي يتحدث عنها الخبراء.

ويتحدث إدوارد سلفادور، من قسم فيزياء الكم والفيزياء الفلكية بمعهد علوم الكون بجامعة برشلونة، الذي شارك هو الآخر في التوقيع على خطاب مارس، عن 3 أخطار أخرى. ويخشى سلفادور، في تصريحات لـ«الشرق الأوسط»، استخدام الذكاء الصناعي للسيطرة على آرائنا السياسية والتأثير على حياتنا الاجتماعية لصالح أقلية ما، وقد يتسبب هذا في فقدان الاهتمام بالحصول على المعلومات والتفكير بحرية، وبهذه الطريقة سنفقد الاستمتاع بحياتنا.

وبالإضافة لهذا الخطر، يتحدث سلفادور عن خطر وجودي، يتمثل في لحظة ستأتي إن لم نضع ضوابط، سيصبح فيها الذكاء الصناعي التوليدي أكثر ذكاءً من البشر، وبعد ذلك، سيكون الذكاء الصناعي قادراً على إنشاء كود جديد بنفسه وتطبيقه على تقدمه الخاص، لذلك سيصبح البشر غير ضروريين. يقول: «قد يبدو هذا خيالاً علمياً، لكنه خطر حقيقي أكثر مما نعتقد».

ويرتبط بهذا الخطر الوجودي خطر آخر، يتمثل في استخدام الذكاء الصناعي بطرق عسكرية أو طرق مدمرة أخرى، وهو ما يفرض في رأيه، ضرورة وضع بعض اللوائح الدولية بشأن تطوير تطبيقات الذكاء الصناعي بشكل مشابه لتلك المتعلقة بالتقنيات الجينية من أجل ضمان التحكم الأخلاقي في الذكاء الصناعي.

ويرى سلفادور أن استقالة هينتون ستمنح مزيداً من الدعم للتوجه السائد حالياً، الذي يطالب بضبط جماح الذكاء الصناعي، لأنه «يتطور بسرعة كبيرة قد تؤدي، إن لم نتحرك سريعاً، إلى فقدان السيطرة عليه، إن أردنا لاحقاً تحقيق ذلك».

[ad_2]

Source link